Vous souhaitez discuter avec nous à propos de votre projet de formation ?

Vous voulez plus d'information sur une formation ou notre fonctionnement ?

Rappel Email

Apprenez à modéliser, construire et optimiser un entrepôt de données avec un processus ETL complet (Pentaho, PostgreSQL, Power BI).

Cette formation ETL & data warehouse vous permettra de comprendre et mettre en œuvre les principes fondamentaux de l’entreposage de données et des processus ETL.

Enfin, vous découvrirez comment connecter votre entrepôt à Power BI pour des analyses de haut niveau.

Cette formation ETL s'adresse aux data scientists, ingénieur·e·s ML, analystes de données souhaitant acquérir de solides compétences de base pour travailler avec les données.

Mises en pratique :

Mises en pratique :

Mises en pratique :

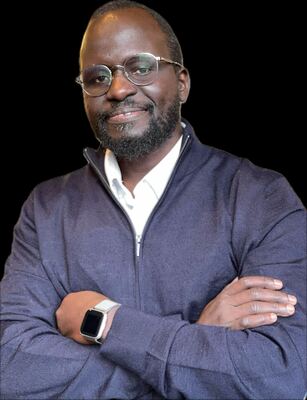

Daouda est docteur-ingénieur en optique et vision par ordinateur. Il a forgé son expertise dans la fibre optique, l'astronomie aérospatiale et le développement d'algorithmes de computer vision pour véhicules autonomes.

Sa maîtrise de C++, Matlab, Python et des technologies comme Hadoop, Spark, SQL et Power BI, acquise notamment lors de sa thèse dont une partie concerne le synchrotron, fait de lui un formateur d’exception.

Que ce soit à l'université ou en milieu professionnel, Daouda forme des data engineers et des data analysts, adaptant ses cours à son public avec des projets concrets. Il sait capter l’attention en mêlant théorie et pratique, permettant aux stagiaires d’appliquer Spark sur des cas réels, comme l’analyse de données événementielles sur un datalake Azure.

Suivez une formation avec Daouda pour transformer vos compétences en data !

Pour en savoir plus, veuillez consulter notre page : Comment financer votre formation ?

Oui, la formation peut être proposée en présentiel ou en distanciel. Pour les inter-entreprises, les modalités (présentiel ou à distance) sont fonction de la session.

Nous pouvons organiser des sessions à d'autres dates ou dans d'autres villes (Bordeaux, Lille, Lyon, Marseille, Montpellier, Nantes, Nice, Paris, Strasbourg, Toulouse...)

Les formations se déroulent toujours en petit groupe de 3 à 6 stagiaires. Nous souhaitons que les formateurs et formatrices puissent passer un maximum de temps avec chacun·e.

Voici une journée type :

* Nombre de personnes ayant répondu au questionnaire de satisfaction sur cette formation depuis 2012